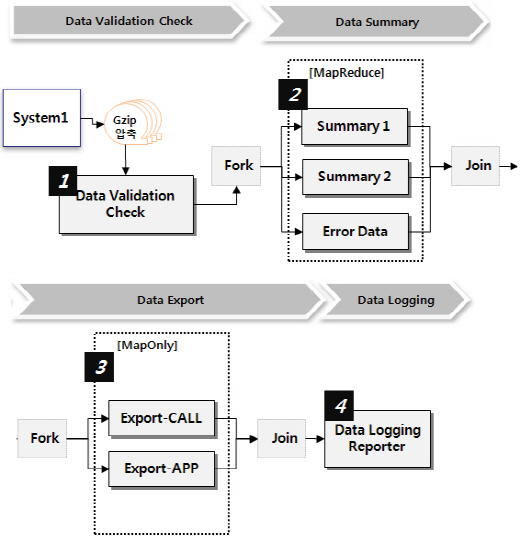

【 Big Data 처리 Process 】

System1에서 Big Data로 원천데이터는 Big Data에서 Data Validation Check, Data Summary,

Data Export, Data Logging 4 단계를 거쳐 데이터 처리 후 서비스로 연동함

① Data Validation Check :

System1에서 유입된 Metadata File과 Input File의 이름, 크기 등의 정합성을 체크

② Data Summary :

Sub1, Sub2 데이터 Cleansing 후 Userdata, APP 별 등으로 시간대 별 요약정보를 생성

③ Data Export : 생성된 시간대 별 요약정보를 서비스의 DB Table에 Upload

④ Data Logging : Upload한 데이터를 분류별로 Input 건수 서비스 DB에 적재